Il 13 luglio 2023 Google Bard è diventato disponibile anche in Italia1. Presentato da molti come la risposta di Alphabet Inc. a ChatGPT, non ha però lo stesso seguito sensazionalistico. Qualcuno tenta qualche timido confronto, ma – sostanzialmente – il nuovo dispositivo viene accolto da un silenzio assordante, su cui voglio ragionare rapidamente, prima di prospettare ipotesi di percorsi formativi per insegnanti.

Nei mesi precedenti, il panorama della cosiddetta Intelligenza Artificiale era stato infatti ridotto dal dibattito su media e social al già citato ChatGPT2, in una discussione subito polarizzata: affatto contrari (in nome del dilagare dell’ignoranza e della pigrizia) contro affatto favorevoli (in nome di inevitabilità e inesorabilità del progresso). Poiché il pubblico degli entusiasti e degli interessati alle nuove opportunità operative era (ed è) rilevante, sono fioriti numerosi corsi, webinar e altri incontri esemplificativi di come usarle “praticamente” nella didattica, tutti imperniati solo su ChatGPT. Nessuno spazio per il nuovo arrivato, che è così finito in ombra. In generale, discorso asfittico, con un campo di riflessione limitato e viziato da empirismo banalizzante.

Estrattivismo culturale e cognitivo all’opera

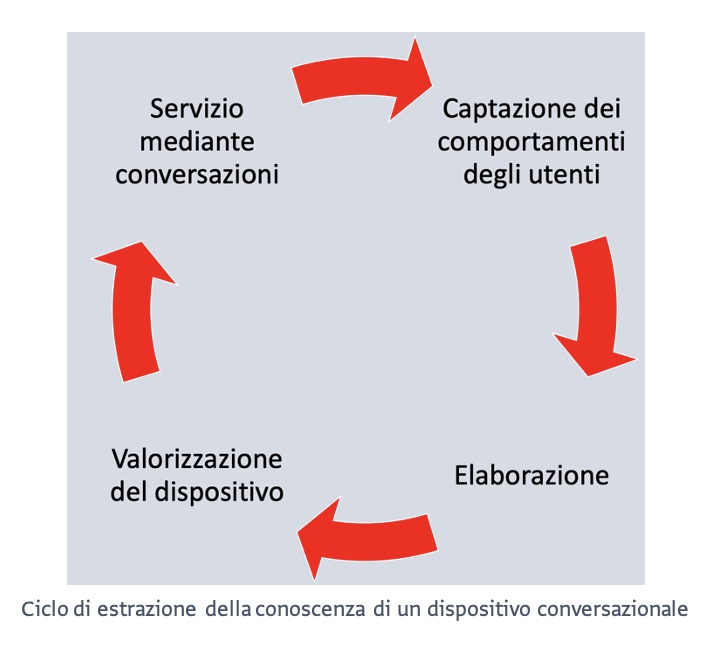

Per chi insegna, accedere a Google Bard è invece doveroso e illuminante. Non solo per scoprire che sono tassativamente richiesti i 18 anni [l’età minima nella maggior parte dei paesi è diventata, nel tempo trascorso tra la stesura e la pubblicazione dell’articolo, 13 anni, N.d.R.]3 e che quindi un impiego diretto da parte degli studenti è improponibile4. Una lettura delle sue impostazioni sulla privacy, infatti, ci fa capire non solo che Alphabet Inc. vuole rispettare il General Data Protection Regulation europeo, ma anche che tra dispositivo e utenti si realizza il medesimo ciclo alla base dei profitti di Google Search sul mercato della conoscenza, lo scambio tra fornitura di un servizio monitorato in tempo reale e utilizzo dei dati degli utenti, in questo caso le conversazioni. Intervengono infatti revisori umani, organizzati in squadre addestrate, che le possono leggere, annotare, elaborare, salvare “a fini qualitativi”, come contributo di adattamento e miglioramento del sistema. Si precisa anche che: «Man mano che Bard si sviluppa, potremmo chiedere il tuo consenso per elaborare le tue informazioni per scopi specifici». Lo stesso processo, peraltro, è sotteso a ChatGPT, già dotato di una versione PLUS a pagamento, 20 dollari USA mensili.

Per chi insegna, accedere a Google Bard è invece doveroso e illuminante. Non solo per scoprire che sono tassativamente richiesti i 18 anni [l’età minima nella maggior parte dei paesi è diventata, nel tempo trascorso tra la stesura e la pubblicazione dell’articolo, 13 anni, N.d.R.]3 e che quindi un impiego diretto da parte degli studenti è improponibile4. Una lettura delle sue impostazioni sulla privacy, infatti, ci fa capire non solo che Alphabet Inc. vuole rispettare il General Data Protection Regulation europeo, ma anche che tra dispositivo e utenti si realizza il medesimo ciclo alla base dei profitti di Google Search sul mercato della conoscenza, lo scambio tra fornitura di un servizio monitorato in tempo reale e utilizzo dei dati degli utenti, in questo caso le conversazioni. Intervengono infatti revisori umani, organizzati in squadre addestrate, che le possono leggere, annotare, elaborare, salvare “a fini qualitativi”, come contributo di adattamento e miglioramento del sistema. Si precisa anche che: «Man mano che Bard si sviluppa, potremmo chiedere il tuo consenso per elaborare le tue informazioni per scopi specifici». Lo stesso processo, peraltro, è sotteso a ChatGPT, già dotato di una versione PLUS a pagamento, 20 dollari USA mensili.

Dimensione civile ed etica della formazione

Quanto visto finora ha a mio giudizio un’implicazione fondamentale: per essere davvero efficace e utile, la formazione degli insegnanti sui dispositivi di IA generativa non può illudersi e illudere di essere in campo neutro, perché il contesto non è tale, sia dal punto di vista civile, sia da quello etico.

L’IA generativa si caratterizza per la rapidissima elaborazione di risposte artificiali plausibili a domande o indicazioni umane, resa possibile dal riferimento a modelli e BigCorpora, costituiti raccogliendo, correlando, analizzando e classificando quantità oceaniche di dati. Questo richiede allenamenti di mega-macchine, ossia proprietà di infrastrutture molto costose e capacità tecnica di impossessamento di BigData, mediante una gigantesca potenza di calcolo. Insomma, poche aziende private captano in tempo reale l’intelligenza collettiva condivisa via internet, presentando l’operazione come raggiungimento di “conoscenza complessiva” con la scansione di materiali liberamente disponibili in rete. Sorvolando però sulla necessità di logistiche ineguagliabili. È pertanto bene chiarire, in premessa, che i dispositivi di IA riaffermano un dominio operativo e culturale oligopolistico già conseguito con “motori di ricerca” e altri servizi individuali e collettivi. Ai fini della piena consapevolezza, questi aspetti sono perfino più importanti dei limiti dei “Large Language Model”5 che alimentano i dispositivi a conversazione simulata, peraltro ben esplicitati da Google Bard:

- Accuratezza: le risposte di Bard potrebbero essere imprecise, specialmente quando vengono poste domande su argomenti complessi o fattuali.

- Bias: le risposte di Bard potrebbero riflettere pregiudizi o prospettive presenti nei suoi dati di addestramento.

- Persona: le risposte di Bard potrebbero suggerire che abbia opinioni o sentimenti personali.

- Falsi positivi e falsi negativi: Bard potrebbe non rispondere ad alcuni suggerimenti appropriati e fornire risposte inappropriate ad altri.

- Vulnerabilità al suggerimento dell’avversario: gli utenti troveranno modi per stressare ulteriormente Bard.

Definizioni e contesto

Sono ora in grado di presentare in modo più preciso la mia ipotesi di formazione, cioè l’uso professionale, critico e consapevole di vari dispositivi di comunicazione artificiale con capacità generative. Questo approccio si sviluppa in un contesto con un’identità e una storia ben definite: il laboratorio “Nuove tecnologie per l’apprendimento” (75 ore di frequenza), che da 10 anni conduco nell’ambito del percorso di specializzazione sul sostegno per l’Università di Torino. Esso coinvolge insegnanti della scuola secondaria di primo e secondo grado, a cui è chiesto di realizzare un “elaborato multimediale” con valenza inclusiva. Ho da tempo definito come obiettivo generale un’autentica emancipazione culturale: l’acquisizione di un lessico analitico, critico e professionalmente davvero incisivo per progettazione, elaborazione e verifica di materiali utili alla mediazione didattica con approccio Universal Design for Learning, capace di superare la gergalità deferente e la superficialità ancillare delle seduttive concettualizzazioni correnti6. L’elaborato multimediale è infatti occasione di dialogo con il tutor e tra i corsisti a proposito di autorialità digitale sostenibile, in termini di tempi di elaborazione, ottimizzazione, semplicità7 e replicabilità dei materiali prodotti, rispetto del diritto d’autore, interoperabilità tra sistemi operativi e device, consapevolezza e controllo sui dati scambiati con i dispositivi coinvolti.

Distinguiamo poi tra autorialità diretta e di secondo livello. La prima è produzione di materiali originali, la seconda selezione, organizzazione, adattamento e cura dell’interattività di materiali presenti in rete. In questo scenario, nell’anno accademico concluso hanno già fatto irruzione vari dispositivi generativi con potenzialità utili per dialogare sull’elaborato multimediale, accolti come “agenti artificiali”, al plurale. Anche su questa base, ho sviluppato una riflessione sistematica e posso definire in modo più chiaro questo segmento della formazione sull’uso dei dispositivi digitali: utilizzo professionale ragionevole e significativo di assistenti artificiali ad attività cognitive mediante prestazioni che imitano quelle umane.

Aspetti epistemologici della ragionevolezza

A indirizzarmi verso la formulazione appena fornita sono state anche alcune letture di approfondimento, quanto mai necessarie per andare oltre sensazionalismo e polarizzazione e per radicare sul piano epistemologico l’impianto della formazione.

Elena Esposito ci fornisce il concetto focale di comunicazione artificiale: gli straordinari risultati dei dispositivi non testimoniano che sono diventati intelligenti, ma che non cercano più di esserlo. La traduzione automatica funziona in base a regolarità e modelli rinvenuti nei testi multilingua reperiti in rete (BigData che diventano BigCorpora) ed è un chiaro esempio di sistema che raggiunge un obiettivo senza capirlo, essendo esperto in statistica e sintassi probabilistica, non in semantica8.

Simone Natale sottolinea come il test di Turing fosse un benevolo inganno: al fine di essere scambiata per un essere umano, la macchina doveva imitarne gli esiti, non i processi interiori9.

Nello Cristianini chiarisce come l’approccio prestazionale sia una svolta: chi progetta i dispositivi rinuncia a comprensione e implementazione totale di caratteristiche e relazioni di causa-effetto di un sistema, a favore della predizione statistica di quello che farà, così come avviene, per esempio, nella composizione automatizzata (generazione) di testi e nell’attribuzione allo spam di mail corrispondenti a determinati pattern. Cristianini approfondisce e generalizza questa prospettiva: la capacità di un soggetto – naturale o artificiale – di agire nel proprio ambiente, in base a informazioni sensoriali, per prendere decisioni efficaci in rapporto a obiettivi definiti, anche in situazioni nuove e a fronte di contromisure ed elementi perturbanti, costituisce infatti il suo concetto di intelligenza svincolata dall’antropocentrismo, molto utile per la comprensione e la descrizione di dispositivi generativi10.

A Junaid Mubeen dobbiamo infine l’idea di complementarità: la storia dei relativi artefatti racconta di come gli uomini abbiano via via realizzato dispositivi capaci di sbrigare gli aspetti esecutivi della matematica (tipicamente i calcoli) con scopo emancipante, perché conferivano loro più tempo e più spazio cognitivo per le attività logico-speculative, la vera qualità culturale11.

I prompt: complementarità tra esseri umani e assistenti artificiali

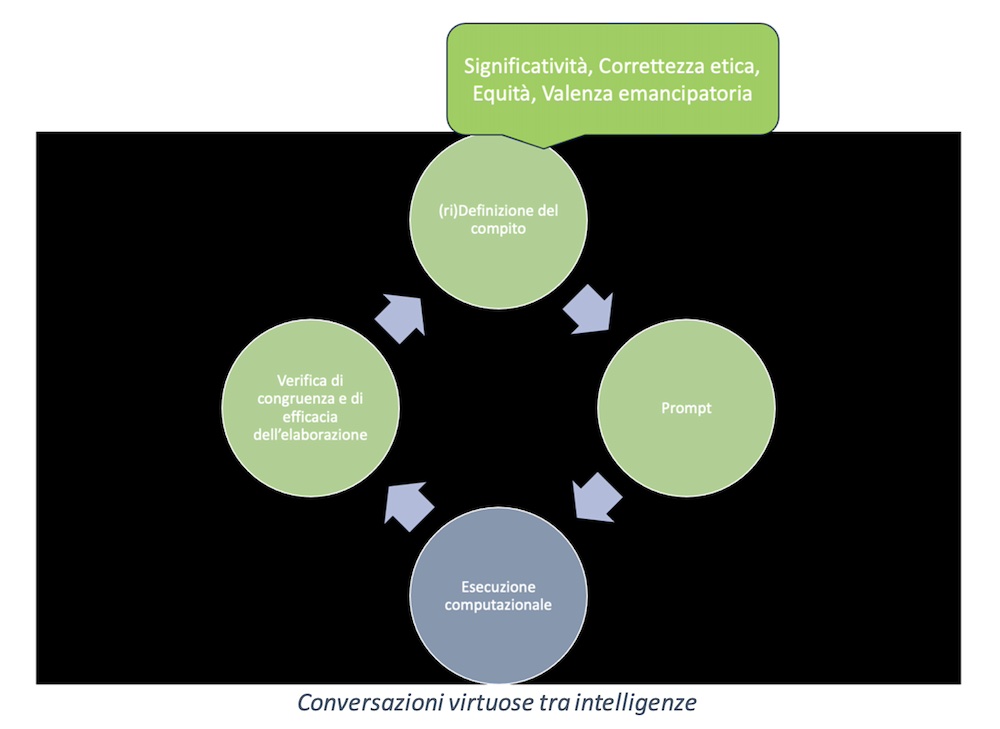

Il ragionamento fin qui ricostruito sugli apparati forniti di intelligenza prestazionale, con particolare riferimento alla pratica della complementarità, mi ha condotto a una scelta molto netta: formare all’impiego degli assistenti artificiali alle attività cognitive in compiti esecutivi e ripetitivi12, continuando a riservare agli esseri umani la responsabilità e il controllo di intenzioni, obiettivi, progettazione dell’elaborazione. Va del resto in questa direzione anche la riflessione sull’autorialità dal punto di vista del diritto: «È l’essere umano a fornire l’input alla macchina e rimaneggiare l’output per avvicinarlo sempre più al risultato desiderato; è l’essere umano a decidere se l’output fornito è adeguato a essere pubblicato o al contrario se necessita [di] ulteriori rimaneggiamenti e aggiustamenti; è l’essere umano a decidere in quali sedi l’output sarà pubblicato e ad assumersene la responsabilità. In quest’ottica dunque anche i sistemi AI generativi, pur ponendosi davvero come qualcosa in grado di mettere pesantemente in crisi il diritto d’autore, riescono comunque ad essere ricondotti sotto il suo campo d’azione»13. Questo principio, avvalorato anche dal concetto di opere “utilitaristiche”14, è a mio giudizio di grande importanza generale, perché chiarisce che l’uso dell’IA generativa può mobilitare capacità culturali e cognitive elevate e raffinate, affermando quindi il primato di un’intelligenza umana evoluta e consapevole delle proprie esigenze ed abilità. Dal punto di vista professionale, invita a procedere in modo chiaro e cogente: prima definire gli obiettivi didattici e appurare dopo se vi siamo assistenti artificiali adatti a supportarne la realizzazione, per la parte esecutiva. Solo così assume senso acquisire – progressivamente, ma con estrema attenzione – la capacità di rivolgere (singolarmente o in gruppo) agli assistenti artificiali richieste articolate di prestazioni cognitive ben definite, ciò che il linguaggio tecnico settoriale chiama prompt. Come rappresentato dallo schema, la definizione del compito da assegnare all’assistente, infatti, non comprende solo accorgimenti di carattere tecnico15: prevede anzi la valutazione di significatività, equità, correttezza etica e valenza emancipatoria del processo che si mette in moto, di nuovo ciclico. La vocazione conversazionale può tradursi in una sequenza dialogica di perfezionamento progressivo, anche per uscire dalla banalizzazione operativa, ma soprattutto culturale e cognitiva, della rigida sequenza [input]-[processo automatizzato]-[output univoco]. Siamo infatti di fronte a una delle caratteristiche generali dei contenuti culturali veicolati su supporto digitale, la plasticità, che riprenderemo.

Il ragionamento fin qui ricostruito sugli apparati forniti di intelligenza prestazionale, con particolare riferimento alla pratica della complementarità, mi ha condotto a una scelta molto netta: formare all’impiego degli assistenti artificiali alle attività cognitive in compiti esecutivi e ripetitivi12, continuando a riservare agli esseri umani la responsabilità e il controllo di intenzioni, obiettivi, progettazione dell’elaborazione. Va del resto in questa direzione anche la riflessione sull’autorialità dal punto di vista del diritto: «È l’essere umano a fornire l’input alla macchina e rimaneggiare l’output per avvicinarlo sempre più al risultato desiderato; è l’essere umano a decidere se l’output fornito è adeguato a essere pubblicato o al contrario se necessita [di] ulteriori rimaneggiamenti e aggiustamenti; è l’essere umano a decidere in quali sedi l’output sarà pubblicato e ad assumersene la responsabilità. In quest’ottica dunque anche i sistemi AI generativi, pur ponendosi davvero come qualcosa in grado di mettere pesantemente in crisi il diritto d’autore, riescono comunque ad essere ricondotti sotto il suo campo d’azione»13. Questo principio, avvalorato anche dal concetto di opere “utilitaristiche”14, è a mio giudizio di grande importanza generale, perché chiarisce che l’uso dell’IA generativa può mobilitare capacità culturali e cognitive elevate e raffinate, affermando quindi il primato di un’intelligenza umana evoluta e consapevole delle proprie esigenze ed abilità. Dal punto di vista professionale, invita a procedere in modo chiaro e cogente: prima definire gli obiettivi didattici e appurare dopo se vi siamo assistenti artificiali adatti a supportarne la realizzazione, per la parte esecutiva. Solo così assume senso acquisire – progressivamente, ma con estrema attenzione – la capacità di rivolgere (singolarmente o in gruppo) agli assistenti artificiali richieste articolate di prestazioni cognitive ben definite, ciò che il linguaggio tecnico settoriale chiama prompt. Come rappresentato dallo schema, la definizione del compito da assegnare all’assistente, infatti, non comprende solo accorgimenti di carattere tecnico15: prevede anzi la valutazione di significatività, equità, correttezza etica e valenza emancipatoria del processo che si mette in moto, di nuovo ciclico. La vocazione conversazionale può tradursi in una sequenza dialogica di perfezionamento progressivo, anche per uscire dalla banalizzazione operativa, ma soprattutto culturale e cognitiva, della rigida sequenza [input]-[processo automatizzato]-[output univoco]. Siamo infatti di fronte a una delle caratteristiche generali dei contenuti culturali veicolati su supporto digitale, la plasticità, che riprenderemo.

Assistenza artificiale (ragionevole) a spunti operativi consolidati

La formazione agli assistenti artificiali si inserisce pertanto nell’insieme degli spunti operativi con capacità inclusiva che storicamente hanno costituito il percorso di lavoro proposto agli specializzandi sul sostegno. Definita la valenza cognitiva, propongo infatti l’esplorazione e l’esercitazione con i dispositivi (generativi, ma non solo) individuati come utili per il perseguimento degli obiettivi di ciascuno di essi. Ad esempio, nel caso delle schematizzazioni grafiche della conoscenza ne spiego e invito a sperimentare le differenti logiche di visualizzazione, congruenti con l’indicazione UDL di utilizzare diverse modalità di rappresentazione per estendere la comprensibilità di materiale concettuale ed espositivo nella direzione dell’apprendimento significativo16. Presento poi due applicazioni generative17 destinate alla costruzione di “mappe”, insieme a due raccomandazioni di valore generale. In primo luogo, diffidare dalle descrizioni entusiastiche, che celano una proposta dispensativa e sostitutiva: la celebrazione della possibilità per gli studenti di produrre mappe automatiche rischia di esonerarli da processi cognitivi che devono invece affrontare direttamente, perché emancipanti e riappropriativi. In secondo luogo, verificare che l’uso di formule come “mappe concettuali”, “mappe mentali” e così via sia rigorosa e non approssimativa e posticcia. Mi convince di più, inoltre, l’assistente che si propone come suggeritore di sviluppi progressivi e singolarmente verificabili della schematizzazione, rispetto a quello che si attribuisce il compito di risolutore di un problema nel suo insieme. Suggerisco infine di sperimentare, come autori diretti di materiali di mediazione didattica, le funzionalità di rappresentazione automatica per argomenti molto consolidati e tradizionali, “scolastici”, che si prestano probabilmente a una prima elaborazione logico-visiva didascalica – tipicamente a blocchi di testo secondo una struttura gerarchica –, da cui costruire un’organizzazione più significativa e personale. In questi casi, infatti, la prima scrematura ha maggiori possibilità di essere convincente, evitando all’insegnante carichi di lavoro professionali privi di autentico significato cognitivo, tipici di una “intelligenza compilativa”.

Questo primo esempio di mobilitazione ragionevole dell’IA disponibile per un certo campo operativo ha due valenze trasversali: l’insegnante può auto-esonerarsi dagli aspetti meccanici e ripetitivi della produzione di materiale per la mediazione didattica e perfezionare via via il lavoro, sfruttando la già citata plasticità e la malleabilità del supporto elettronico. È infatti nota ed evidente la perfettibilità della scrittura di testi mediante programmi di word processing. In questo caso, l’assistenza artificiale ragionevole può innanzitutto consistere in dettatura, trascrizione, traduzione19, sia di testi completi e autosufficienti, sia di materiali frammentati, da aggregare con dispositivi dedicati (cfr. infra). In entrambi i casi, l’assistenza artificiale ragionevole può ridurre il carico cognitivo superfluo derivante dalla redazione ripetitiva di testi a scopo esercitativo e/o esemplificativo, a bassa o nulla significatività cognitiva per l’insegnante. Per far ciò ChatGPT e Google Bard – dispositivi conversazionali general purpose – richiedono prompt molto curati e dialoghi di raffinamento, ma altri dispositivi20 sono impostati in modo più agile, perché danno anche la possibilità di scegliere funzionalità (riduzione, ampliamento, semplificazione) e caratteristiche (tono, lunghezza, scopo, punto di vista autoriale e così via) preimpostate. Questa duplice modalità si può ribaltare produttivamente sulla comprensibilità dei testi, perché aprono la strada al perfezionamento delle relative istruzioni sulla base dei protocolli di adattamento dei libri di testo21.

Gli assistenti alla redazione di testi, poi, intervengono anche sul rapporto cognitivo e operativo tra processo di scrittura e realizzazione di articoli per i blog, il cui focus è testo. Storicamente, gli specializzandi sul sostegno hanno fatto ricorso a blog per accumulare nel tempo materiali didattici anche molto differenti tra loro sotto forma di post, prevedendo però di poterli e riorganizzare con criteri diversi, etichette semantico-funzionali (“categorie”) che ne consentono riaggregazioni dinamiche, in funzione di esigenze diverse degli utenti. In più, la disponibilità di assistenti artificiali alla redazione di testi suggerisce di immaginare blog “di servizio”, non per un pubblico di fruitori degli articoli, ma come magazzini e officine di manipolazione di testi a scopo didattico.

Anche la produzione di libri digitali e lo storytelling possono trovare vantaggio dall’impiego di assistenti artificiali alla redazione di testi, per ampliare lo spettro del materiale esemplificativo ed esercitativo, a cui può essere associata la generazione automatizzata di immagini22. Nella storia del percorso di specializzazione, peraltro, le immagini sono state “croce e delizia”. Se “far vedere” permette inclusione, va rispettato il diritto d’autore e non sempre sono disponibili immagini libere da questo vincolo. È quindi del tutto evidente il beneficio di generare immagini personalizzate trasformando le proprie esigenze in un prompt23. Ancor più, in considerazione del fatto che molti corsisti hanno scelto (e sceglieranno) di realizzare “immagini interattive”, su cui collocare simboli visivi che rimandano a collegamenti, con lo scopo di rendere esplicito e direttamente accessibile il tessuto di apprendimento sotteso a “ciò che si vede”24.

È importante aver chiaro che, in generale, l’efficacia e la congruenza delle immagini non vanno misurate in termini espressivi, estetici e stilistici, ma su base cognitiva, ovvero sull’effettiva capacità di rappresentare ciò a cui di volta in volta si riferiscono, una sorta di consapevole concettualizzazione by e in prompt. L’esplicitazione del tessuto di apprendimento sotteso a un’immagine con una sua trasformazione che le aggiunge interattività può essere definita “estensione ipermediale”. Questa formulazione generale riguarda la possibilità tecnica, ma soprattutto cognitiva e culturale, di collegare l’una all’altra unità informative anche molto diverse, tanto più che QRcode e tecnologie della comunicazione di prossimità hanno da tempo reso “linkabili” a contenuti digitali anche gli oggetti materiali. Bene: sono ipermedialmente estendibili anche i filmati, in streaming da Youtube o prodotti direttamente25.

Se l’utilità degli assistenti alla produzione di video26 è scontata, vanno considerati con grande attenzione gli applicativi che consentono di ottenere resoconti e sintesi del contenuto di filmati presenti su YouTube, come elenchi puntati o articoli estesi27, combinando accesso alla sottotitolazione, capacità di traduzione e di manipolazione testuale dei chatbot, a cui gli applicativi inviano prompt molto dettagliati.

Il materiale prodotto può essere copiato e incollato dovunque accrescendo l’accessibilità28 e la comprensibilità del flusso video originale mediante diverse forme di coinvolgimento e di espressione. Testi, immagini, video realizzati con dispositivi generativi possono infine confluire in percorsi didattici strutturati sfruttando diversi aggregatori, così come gli applicativi destinati alla gestione e al monitoraggio di quiz possono essere alimentati con materiale prodotto dai chatbot testuali29. Oltre che, ovviamente, da unità informative recuperate con una ricerca su internet: in questo caso la conversazione simulata può intervenire in modo utile, se restituisce contenuti già strutturati attendibili ed esaustivi e, soprattutto, se indica le fonti a cui ha attinto per la propria “risposta cumulativa”30. Altra opzione utile è l’indicazione da parte del sistema di possibili sviluppi della conversazione31.

Concludendo, mi sembra che questo progetto preveda per ciascuno degli spunti del percorso di formazione (consolidato negli anni e via via integrato con gli applicativi intervenuti a semplificare il piano operativo e potenziare quello cognitivo) una coerente espansione quantitativa di analisi e sperimentazione dei potenziali assistenti artificiali. Sarà l’attenzione professionale degli esseri umani – gli autentici protagonisti dell’attività – a verificare criticamente se si verificherà anche un incremento qualitativo.

Note

- In precedenza, il dispositivo escludeva gli utenti della comunità europea, con lo stesso accorgimento adottato da ChatGPT dopo le osservazioni del Garante della privacy, cioè il blocco degli indirizzi IP di quella provenienza.

- Più precisamente: il variegato insieme dell’IA è stato identificato con la sola intelligenza artificiale “generativa”, dimenticando motori di raccomandazione commerciale, logistica di lavoro e distribuzione, ranking nella ricerca, combinazione di profili nei siti di incontri e così via. E quella generativa con le conversazioni, relegando in un angolo la produzione di immagini in base a indicazioni testuali.

- Guida a Bard disponibile all’indirizzo https://support.google.com/bard?sjid=12445836213057268994-EU#topic=13194540.

- L’età minima richiesta da ChatGPT è invece 13 anni.

- Gli LLM sono algoritmi di Deep Learning (apprendimento profondo basato su reti neurali) in grado capaci di riconoscere contenuti, riassumerli, espanderli, tradurli e prevederli in base ad addestramento su enormi set di dati.

- Chi fosse interessato ad approfondire può raggiungere https://udlinbit.school.blog/.

- Intesa come facilitazione operativa potente per estensione cognitiva, non come trivializzazione, banalizzazione.

- E. Esposito, Comunicazione artificiale. Come gli algoritmi producono intelligenza sociale, Bocconi University Press, Milano 2022.

- S. Natale, Macchine ingannevoli. Comunicazione, tecnologia, intelligenza artificiale, Einaudi, Torino 2022.

- N. Cristianini, La scorciatoia. Come le macchine sono diventate intelligenti senza pensare in modo umano, il Mulino, Bologna 2023.

- J. Mubeen, L’intelligenza matematica. Cosa abbiamo che le macchine non hanno, Einaudi, Torino 2023.

- Questa impostazione è del resto quella di vari dispositivi di IA di tipo non generativo, come la trascrizione di file audio (“sbobinatura”), fatica cognitiva mai considerata prestazione intellettuale: al termine della prestazione automatizzata, sarà l’intelligenza umana a giudicare l’efficacia di quanto ottenuto, intervenendo a migliorarla, se necessario.

- S. Aliprandi, L’autore artificiale. Creatività e proprietà intellettuale nell’era dell’AI, Ledizioni, Milano 2023.

- L. Chimienti, Diritto d’autore 4.0. L’intelligenza artificiale crea?, Pacini Editore, Pisa 2020.

- Mi preoccupa molto, invece, l’opportunistico proliferare di iniziative di micro-formazione al prompt engineering, inteso come insieme di virtuosismi tecnici, o la rivendita di liste di indicazioni preconfezionate. Molto più utili sono analisi e decostruzione di formulazioni usate da altri utenti in rapporto con i risultati raggiunti, possibile per esempio su Midjourney.com.

- M. Guastavigna, Non solo concettuali. Mappe, schemi, apprendimento, I Quaderni della Ricerca n. 23, Lœscher, Torino 2015.

- Si tratta di Algor Education e Whimsical. Qui e altrove, per non appesantire il testo, citerò i nomi commerciali degli assistenti artificiali indicati, assumendo che chi fosse interessato li potrà facilmente reperire e provare ricorrendo a un motore di ricerca.

- Un’ampia trattazione di questo tema è contenuta in M. Guastavigna, Risorse digitali per la scrittura, in Parla come badi, «La ricerca» n. 10, Lœscher., Torino 2016.

- Questa funzionalità ha raggiunto risultati accettabili ed è ormai una risorsa di carattere generale, con cui realizzare versioni diverse degli stessi testi, destinate magari agli studenti in difficoltà in italiano, a cui possono essere fornite anche rappresentazioni grafiche salvate come immagini e trattate da Google traduttore.

- Ad esempio, Microsoft Bing in modalità “Composizione”, l’assistente AI Jetpack (inserito di default in WordPress), scrittura magica di Canva e numerosi altri applicativi.

- Sul tema cfr. M. Guastavigna, Il paradosso della semplificazione, in Parla come badi, «La ricerca» n. 10, Lœscher, Torino 2016.

- È il caso di Tome.app.

- I dispositivi più noti sono Midjourney, Image Creator from Microsoft Bing, Adobe Firefly, Dall-e 2, Night Café, Stable diffusion. Sono prevalentemente free, ma un impiego consistente e continuo richiede una licenza, questione non risolvibile attingendo alle risorse economiche dei singoli insegnanti.

- Lo fanno, ad esempio, Lumi Education e Thinglink.

- Nel laboratorio abbiamo usato Lumi Education e Edpuzzle, ma vi sono molti altri applicativi.

- Segnaliamo Clipchamp di Microsoft, ma si tratta di un settore in continua espansione, per numero di applicativi e quantità di funzioni implementate, si veda https://www.navigaweb.net/2023/04/migliori-generatori-di-video-ia-per.html.

- Per esempio, YouTubeDigest e Merlin, estensioni per browser.

- Per quanto riguarda accessibilità e comprensibilità su un piano più generale, ricordo che PowerPoint ha due moduli di IA che possono accompagnare la produzione e lo svolgimento di una presentazione: “Designer”, che propone layout di impaginazione in funzione dei contenuti via via collocati sulla diapositiva e “Sottotitoli” automatici, che possono essere attivati anche in una lingua diversa da quella del relatore. Word ha una funzione “Editor” – disponibile anche come estensione per alcuni browser – che utilizza un indice di comprensibilità del testo e suggerisce alcune possibili perfezionamenti e correzioni.

- Segnalo a questo proposito ChatPDF e UPDF, che scansionano un documento in formato pdf e consentono di dialogare specificamente sul suo contenuto, e Diffit, che adatta ai diversi livelli dell’istruzione USA, dal secondo all’undicesimo grado, il contenuto di un testo caricato dall’utente o raggiungibile via Internet; entrambi i potenziali assistenti sono inoltre multilingua e i loro prodotti editabili.

- Il già citato Diffit, ad esempio, ha una particolare logica operativa: genera schede didattiche strutturate, graduate per livello di istruzione ed editabili, su un tema indicato dall’utente e fornisce in modo puntuale gli URL a cui fa riferimento. Microsoft Bing in modalità chat indica gli URL a cui ha attinto. Google Bard è collegato in modo diretto con Google Search. ChatGPT, se interpellato, risponde: “non ho accesso diretto alle mie fonti né posso citarle specificamente. […] le mie risposte sono il risultato della mia comprensione delle informazioni fornite durante l’addestramento”.

- Mentre scrivo, il più lineare in questo è di nuovo Microsoft Bing.