«I bot sono le nuove app», dichiarava Satya Nadella, CEO di Microsoft, alla Conferenza per sviluppatori nel 2016, in occasione del lancio di Cortana. La sua visione del futuro dell’interazione fra gli umani e le macchine era «conversazione come piattaforma», in cui l’Intelligenza Artificiale (IA) avrebbe consentito ai computer di interagire con le persone, utilizzando l’interfaccia umana più naturale, il linguaggio, per cui era necessario «infondere nei computer informazioni su di noi e sul nostro contesto».

I bot sono i programmi che lavorano dietro le quinte per migliorare l’esperienza degli utenti sul web: forniscono suggerimenti di ricerca (se hai acquistato questo, ti piacerà anche quest’altro), previsioni meteo, filtrano le email, ripuliscono le voci di Wikipedia. I bot sono stati adattati per agire sui social media: sono masse di utenti fittizi, i cosiddetti social bot1, pilotati come squadriglie (bot squad) d’assalto contro personaggi scomodi o per influenzare l’opinione pubblica in momenti critici come le elezioni politiche, come documentato da indagini giornalistiche e studi scientifici2.

I chatbot, programmi specializzati nel simulare la conversazione umana, sono molto utilizzati come assistenti alla clientela. È significativo che il rapporto della Harvard Business Review3 rivolto a misurare quanto le imprese siano pronte ad affrontare la sfida della trasformazione digitale, fortemente accelerata dalla pandemia, insista sulla necessità di investire in chatbot, che siano “empatici”: le aziende dovranno essere «in grado di collegare i canali e di fornire interazioni simili a quelle umane e attivabili, che portino a risultati aziendali positivi. In breve, dovranno investire in tecnologie che aumentino e scalino le competenze trasversali che i loro migliori dipendenti apportano ai rapporti con i clienti: la capacità non solo di ascoltare il cliente, ma di sentire effettivamente ciò che dice, di entrare in empatia con lui e di intraprendere azioni che soddisfino le sue aspettative».

«Alessa ti voglio bene», dice il bambino di 4 anni abituato a interagire con la voce – femminile – che è stata progettata per incentivare acquisti su Amazon. Alexa è un bot che, come tutti gli assistenti vocali, registra tutte le interazioni della famiglia ed è in grado di riconoscere le impronte vocali di tutti i membri, i gusti musicali e gli interessi. A maggio 2023 Amazon ha accettato di pagare 25 milioni di dollari4 per chiudere la causa federale negli Stati Uniti per aver conservato indefinitamente le registrazioni vocali dei bambini, violando la legge federale sulla privacy dei bambini online.

ChatGPT ecc.

ChatGPT è un chatbot, progettato per interagire con gli utenti usando il linguaggio naturale. Si basa su tecniche di apprendimento automatico per analizzare basi dati di grandi dimensioni e produrre risposte plausibili alle richieste – i prompt – degli utenti.

Come funziona

Senza addentrarsi in spiegazioni tecnologiche, il funzionamento del LLM (Large Language Model o modello linguistico di grandi dimensioni) è stato paragonato a un «pappagallo stocastico»5, pappagallo perché nelle risposte ripete cose già sentite e stocastico perché anticipa un fenomeno in termini di statistica e probabilità: di fatto il sistema analizza porzioni di testo a cui associa parole che hanno una frequenza statistica maggiore e una più alta probabilità. Un LLM non comprende il senso della domanda né la risposta che fornisce. Grazie a un’infinità di parametri il sistema produce frasi di senso compiuto e di contenuto plausibile, analizzando il contesto in cui sono fornite.

Gli aspetti più interessanti introdotti da Chat- GPT3 rispetto al precedente ChatGPT2 sono la possibilità di interagire attraverso comandi con parametri, che permettono di definire meglio il tipo di output richiesto e la possibilità di successive iterazioni sull’output ottenuto senza dover ricominciare da capo, in un processo di raffinamento che utilizza i feedback umani (Rafforzamento dell’Apprendimento grazie ai Feedback Umani o RLHF).

L’approccio probabilistico adottato dagli LLM rispetto a uno basato su regole non è necessariamente uno svantaggio, secondo alcuni, perché li rende strumenti versatili e flessibili: l’idea è di usare le funzionalità del motore LLM come un processore che riceve input e produce output, che non siano necessariamente testi di una conversazione6.

I nuovi LLM si basano su un modello chiamato Transformer7, progettato da Google nel 2017. Questo modello analizza i token (parole o porzioni di parole) all’interno di un testo e poi le relazioni fra i vari token, per determinare qual è quello più importante. Quest’analisi si svolge in unico passaggio e non attraverso passi sequenziali come nelle reti neurali: ciò rende il sistema molto più efficiente, permettendogli di identificare il significato all’interno di uno specifico contesto e di produrre variazioni o sintesi plausibili. Tale modalità di analizzare “pattern”, cioè strutture ricorrenti, è utilizzata anche per generare immagini e suoni da sistemi come Dall-E, Midjourney e Stable Diffusion, e codice del computer utilizzando generatori come GitHub CoPilot.

L’impatto sociale

ChatGPT3.5, la prima applicazione gratuita di LLM, è stata rilasciata pubblicamente e gratuitamente in un formato sperimentale, alla fine del 2022, come dichiarato da OpenAI: «ChatGPT è un modello gemello di InstructGPT, che è addestrato a seguire un’istruzione in un prompt e a fornire una risposta dettagliata. Siamo entusiasti di presentare ChatGPT per ottenere il feedback degli utenti e conoscere i suoi punti di forza e di debolezza. Durante l’anteprima della ricerca, l’uso di ChatGPT è gratuito. Provatelo subito su chat.openai.com.» coinvolgendo milioni di persone nel ruolo di tester volontari e non pagati.

LLM come ChatGPT sono molto efficaci nella produzione massiva di testi (intesi in senso lato includendo codice sorgente e multimedia) con costi risibili e una velocità incomparabile con quella umana: sono in grado di produrre testi in lingue e stili diversi, possono conversare simulando di essere uno scrittore inglese del Cinquecento, un insegnante che deve preparare una lezione o addirittura un santo8.

È estremamente semplice porre domande e avere risposte, ma per avere risultati di valore bisogna imparare a costruire domande circostanziate e molto dettagliate. Inoltre, il massiccio stress-test a cui questi sistemi sono stati sottoposti – si parla di 10 milioni di utenti al giorno da dicembre 2022 ad aprile 2023 – ha evidenziato falle di sicurezza nella gestione dei dati personali; ad esempio, il sistema riutilizzava parti di dialogo di altri utenti.

ChatGPT3.5 ha creato grandi aspettative e qualche immediata delusione: gli LLM non eccellono nella logica per la loro intrinseca natura, quindi le risposte che prevedevano qualche ragionamento a partire dai dati contenuti nella data erano palesemente errate. In poco tempo è stato evidente che le risposte non sono sempre accurate e se il sistema non ha a disposizione informazioni sufficienti per rispondere alle domande, le inventa, dando luogo alle cosiddette allucinazioni. Tali limiti sono pubblicamente dichiarati in un linguaggio molto chiaro: «ChatGPT a volte scrive risposte plausibili ma non corrette o senza senso. Risolvere questo problema è impegnativo durante l’addestramento nella vita reale e non esiste alcuna fonte di verità[…]». Nonostante queste avvertenze, si sono verificate situazioni molto problematiche: casi eclatanti sono quelli dell’avvocato che ha citato sentenze inesistenti in un processo9 e del professore infamato da accuse di inesistenti scandali sessuali10.

Gli LLM sono progettati per simulare dialoghi reali ma «Non hanno empatia, né alcuna comprensione del linguaggio che stanno producendo, né alcuna comprensione della situazione in cui si trovano. Ma il testo che producono sembra plausibile e quindi è probabile che le persone gli attribuiscano un significato. Lanciare qualcosa del genere in situazioni delicate significa correre rischi sconosciuti. Una domanda chiave da porsi è: chi è responsabile se l’IA fornisce suggerimenti dannosi? In questo contesto, l’azienda che sta implementando l’esperimento sta affidando tutta la responsabilità ai membri della comunità che scelgono il sistema di intelligenza artificiale?»11.

Al momento del suo debutto, ChatGPT non prevedeva alcun controllo per l’accesso di minori né informative sul trattamento dei dati: per questo il Garante per la Protezione dei Dati ha bloccato OpenAI in Italia, provocando il disappunto di milioni di utenti, che tuttavia facilmente aggiravano il blocco utilizzando sistemi per mascherare la provenienza (tramite VPN) o applicazioni create per l’occasione. L’accesso è stato ripristinato dopo qualche settimana a seguito dell’adeguamento da parte di OpenAI. Nonostante il provvedimento sia stato un’operazione dovuta, le reazioni sono state quasi unanimi nell’esprimere insofferenza verso il GDPR, vissuto da molti come un’inutile burocratica complicazione, in grado di bloccare lo sviluppo tecnologico dell’Italia.

La fine del genere umano?

ChatGPT ha continuato a catalizzare l’attenzione per tutto il primo semestre del 2023, e mentre ci si interrogava sull’impatto che questi strumenti avrebbero avuto sull’occupazione e l’informazione, sull’istruzione e sulla democrazia, 350 esperti (diventati 600 a settembre) sottoscrivevano la seguente dichiarazione «Mitigare il rischio di estinzione da parte dell’I.A. dovrebbe essere una priorità globale insieme ad altri rischi su scala sociale come le pandemie e la guerra nucleare».

Una dichiarazione molto potente e in grado di creare una grande ansia dovuta al presunto prossimo avvento di una IA Generalista (IAG), che pure essendo rischiosa promette di essere vantaggiosa per il genere umano. Se vi ricorda qualcosa, Sam Altman ha citato la famosa frase «La tecnologia sta accadendo perché è possibile», e ha paragonato la sua azienda al progetto Manhattan.

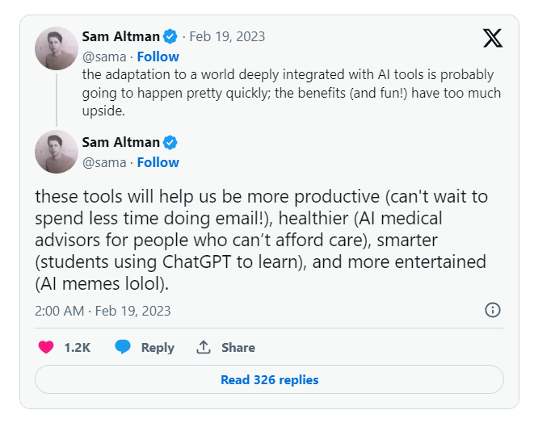

E. Morozov, in un articolo pubblicato sul New York Times a giugno 2023, ha evidenziato come i rischi paventati dagli esperti non siano futuri ma già attuali, a partire dal fatto che «presentare la sua comparsa come quasi inevitabile distrae dalla ricerca di modi migliori per aumentare l’intelligenza». Morozov usa gli esempi di varie startup che non sono riuscite a mantenere le loro promesse, come Uber, che doveva rivoluzionare il trasporto pubblico con veicoli a guida autonoma con costi minimi di personale, o Theranos, la cui fondatrice è in galera per frode: i suoi dispositivi innovativi per l’analisi del sangue non sono mai esistiti. Airbnb, TaskRabbit e Facebook sono altre startup che promettevano di risolvere problemi e migliorare la vita dei loro utenti, ma che hanno creato anche nuove problematiche: favorendo la gentrificazione delle città, la diffusione della precarietà e di notizie false. Anche ChatGPT promette di risolvere tanti problemi, in settori come la salute e l’istruzione, infatti potrà fornire consigli a chi non può permettersi un medico (post Twitter di Sam Altman del 19 febbraio 2023); ancora, «L’intelligenza artificiale sarà un buon tutor come qualsiasi essere umano, ma i profitti nell’istruzione richiederanno tempo», secondo Bill Gates.

La scuola distopica del futuro

Le dichiarazioni di Bill Gates alimentano una delle distopie più diffuse sul futuro, forse iniziate nel 1951 dal racconto di Asimov Come si divertivano12 che descrive una scuola in cui gli insegnanti sono sostituiti dai robot. La diffusione dei computer personali ha ulteriormente alimentato questa distopia: la BBC nel 1984, in un programma per ragazzi, presentava un PC IBM che rispondeva ai comandi vocali. Qualche anno dopo, nel 2010, il professor Sugata Mitra, attraverso il suo esperimento con gli studenti in India chiamato Hole in the wall (il buco nel muro), teorizzava il potenziale dei computer per sostenere l’apprendimento senza l’intervento degli adulti: un progetto che gli valse il TED Prize di 1 milione di dollari ma anche qualche dubbio sulla sua efficacia. Con la diffusione di smartphone, ambienti virtuali e IA, complici la pandemia e la didattica a distanza, questo futuro distopico sembra sempre più prossimo.

Esistono numerosi e reiterati progetti promossi da giganti del software che vogliono re-inventare la scuola, soprattutto negli Stati Uniti: il loro approccio è diverso rispetto a quello dei grandi capitani di industria che agivano sulle istituzioni. Nel tempo le soluzioni tecnologiche sono proposte direttamente alle famiglie e agli insegnanti, ad esempio attraverso i social network. Netflix e Facebook hanno creato e distribuito software per l’apprendimento personalizzato e adattivo, che tuttavia non hanno dato risultati in termini di miglioramento dell’apprendimento, e che secondo alcune ricerche potrebbero attribuire falsamente al software risultati migliori dovuti a insegnanti migliori.

Un esempio recentissimo di scuola del futuro potenziata dall’IA è Khanmigo13, l’evoluzione della Khan Academy14. Il servizio è accessibile da maggio 2023, è a pagamento (chiamate donazioni sul sito) e si basa su ChatGPT4. È progettato come un tutor che adotta il metodo socratico per aiutare gli studenti ad imparare, quindi non fornisce risposte. Khan sostiene che Khanmigo sia la soluzione al problema Sigma2 di Benjamin Bloom15: la ricerca pubblicata nel 1984 che dimostrava che gli studenti con un insegnante dedicato aveva risultati migliori di uno studente che studiava in un contesto di classe tradizionale. Un problema di difficile soluzione: garantire un insegnane per ogni studente perché «troppo costoso per la maggior parte delle società da sostenere su larga scala» ma non per Khanmigo! L’assistente virtuale ha anche una versione per supportare gli insegnanti nella creazione di lezioni.

E gli studenti? Che ne pensano? Il New York Times16 ha chiesto agli studenti di commentare l’articolo che presenta la sperimentazione di Khanmigo in una scuola. Nei 300 e passa commenti pubblicati si scopre che per la maggior parte non vorrebbero una IA come tutor, anche se riconoscono possa essere utile in alcuni casi. Lamentano che l’IA dà troppe informazioni, a volte incorrette, e non è utile che faccia i compiti al loro posto; qualcuno invece ritiene che poter interrogare un esperto onnisciente in qualsiasi momento sia un grande vantaggio; un altro commento invece ritiene che l’IA a scuola dovrebbe essere vietata.

Il tutoraggio individuale è da sempre considerato il santo graal dalle aziende edtech: oggi ci sono decine di chatbot per l’educazione e altre applicazioni educative che usano l’IA e altrettanti siti che li raccolgono17.

Come ben descritto nella scheda di lavoro in progress pubblicata su La ricerca online18 le e gli insegnanti sono invitati a esplorare una pluralità di “assistenti artificiali” per valutarne l’uso in coerenza con gli obiettivi didattici. L’ultima delle raccomandazioni della scheda insiste sulla creazione di una policy d’istituto.

Le linee guida

Al di là del clamore sollevato da ChatGPT, da tempo i governi e istituzioni sovranazionali emettono linee guida per regolamentare le IA. Secondo l’Osservatorio sull’IA dell’OCSE19, a settembre 2023 sono più di 800 le linee guida emesse da 69 Paesi nel mondo. L’UNESCO ha effettuato una prima classificazione delle linee guide sull’IA applicata all’educazione nel 2021 e ha evidenziato aree di comune interesse, quali la protezione dei dati e della privacy, l’apertura e la trasparenza delle tecnologie e dei dati, la risposta dei sistemi educativi alle richieste di un nuovo mercato e l’esigenza di finanziamenti per l’implementazione di programmi formativi. Da allora, il contesto è cambiato molto, come le attese e le aspettative verso le IA: le più recenti dichiarazioni UNESCO20 invitano a un’attenta valutazione delle scuole nell’introduzione di tali strumenti, ricordando ad esempio le procedure e i tempi che regolano l’adozione di libri di testo. Anche le Linee guida sulle Intelligenze artificiali generative21 di recentissima pubblicazione suggeriscono diversi punti di attenzione per i politici, tra i quali il trattamento dati degli utenti, il controllo umano nei processi decisionali, la necessità di trasparenza e di formazione per insegnanti e studenti; inoltre consigliano un limite minimo di età fissato a 13 anni per l’accesso autonomo, sulla scia di regolamentazioni già esistenti22.

Secondo un’indagine UNESCO (non pubblicata) del marzo 2023, su 450 scuole e università nel mondo solo il 10% ha definito una politica interna sull’uso delle intelligenze generative: la mancanza di adeguate riflessioni sull’uso delle IA potrebbe portare a conseguenze indesiderate.

Conclusioni

Chiunque operi nel settore della conoscenza dovrebbe formarsi sul tema delle IA generative, non solo per quanto riguarda un addestramento tecnico a scrivere prompt efficaci (non tutti devono diventare prompt engineer). È necessario creare una consapevolezza che permetta di comprendere che il determinismo del mercato non sempre coincide con gli interessi della comunità, e che le politiche, i regolamenti e tutta la noiosa burocrazia che invita al rispetto della centralità umana, all’uso etico e trasparente dell’IA, servono a tutelarci e vanno compresi, rispettati e fatti rispettare.

Bibliografia

I. Asimov, Chissà come si divertivano in Il meglio di Asimov, Trad. I. Brinis, Arnoldo Mondadori Editore, Milano 1994

A. Atzei, L. Ballestra, C. Caffaratta, L. Bozzetto, A. Forno, M. Secchia, A. Zando, Impostare percorsi di formazione di insegnanti sull’assistenza artificiale alla mediazione didattica, LOESCHER, 2023, ISSN 2282-2852 https://laricerca.loescher.it/autori/atzei-caffaratti-borghetti-bozzetto-forno-secchia-zanzo/

M. Bakardjieva, R. Gehl, Socialbots and Their Friends: Digital Media and the Automation of Sociality, United States: Taylor & Francis, 2018

E. Bender, et al. “On the dangers of stochastic parrots: Can language models be too big.” Proceedings of the 2020 Conference on Fairness, Accountability, and Transparency; Association for Computing Machinery, New York, NY, USA. 2021. https://dl.acm.org/doi/10.1145/3442188.3445922

G. Caldarelli, R. De Nicola, F. Del Vigna et al., The role of bot squads in the political propaganda in Twitter. Commun Phys 3, 81 (2020). https://doi.org/10.1038/s42005-020-0340-4

De Faveri, F.L., Cosuti, L., Tricomi, P.P., Conti, M. (2023), Twitter Bots Influence on the Russo-Ukrainian War During the 2022 Italian General Elections. , in B. Arief, A. Monreale, M, Sirivianos, S. Li, (a cur di) Security and Privacy in Social Networks and Big Data. SocialSec 2023. Lecture Notes in Computer Science, vol 14097. Springer, Singapore. https://doi.org/10.1007/978-981-99-5177-2_3

Automating and Scaling the Soft Skills Critical to Customer Experience in a Digital-First World Report by Harvard Business Reviews sponsored by Verint, 2022 https://hbr.org/sponsored/2022/01/automating-and-scaling-the-soft-skills-critical-to-customer-experience-in-a-digital-first-world-report

C. O’Neil, Armi di distruzione matematica, trad. it. di D. Cavallini, Bompiani, Milano 2017.

F. Miao, W. Holmes, Guidance for Generative AI in Education and Research, UNESCO, 2023. https://unesdoc.unesco.org/ark:/48223/pf0000386693.locale=en

S. Giannini, Generative AI and the future of education, UNESCO, 2023

Note

- M. Bakardjieva, R. Gehl, Socialbots and Their Friends: Digital Media and the Automation of Sociality, Taylor & Francis, USA 2018.

- Cfr. G. Caldarelli, R. De Nicola, F. Del Vigna et al., The role of bot squads in the political propaganda, in «Communications Physics» 3, 81, 2020, e F.L. De Faveri, L. Cosuti, P.P. Tricomi, M. Conti, Twitter Bots Influence on the Russo-Ukrainian War During the 2022 Italian General Elections, in B. Arief, A. Monreale, M, Sirivianos, S. Li (a cura di), Security and Privacy in Social Networks and Big Data, in «SocialSec 2023. Lecture Notes in Computer Science», vol. 14097, Springer, Singapore 2003.

- Consultabile all’indirizzo https://bit.ly/45muZe8.

- Cfr. https://www.nytimes.com/2023/05/31/technology/amazon-25-million-childrens-privacy.html.

- Si veda E. Bender et al., On the dangers of stochastic parrots: Can language models be too big, Proceedings of the 2020 Conference on Fairness, Accountability, and Transparency; Association for Computing Machinery, New York, NY, USA 2021.

- Cfr https://bit.ly/3tfrNDS.

- Sul funzionamento degli LLM si veda https://ig.ft.com/generative-ai/.

- Cfr. https://www.wired.it/article/bot-chattare-santi-prega-org/.

- Cfr. https://www.corriere.it/esteri/23_maggio_28/avvocato-aula-new-york-chatgpt-che-si-sbaglia-cita-sentenze-fasulle-e2d8ad88-fd80-11ed-8aba-45a422ecf4be.shtml.

- Cfr. qui https://bit.ly/45olJWW e qui https://bit.ly/46GW394.

- Il commento di Bender è relativo all’uso di chatbot per la salute mentale e si legge qui https://bit.ly/3tnrPK0.

- Si veda https://bit.ly/3ZJD9w0.

- Cfr. https://www.khanacademy.org/khan-labs#khanmigo

- Cfr. https://www.khanacademy.org/

- Cfr. https://en.wikipedia.org/wiki/Bloom%27s_2_sigma_problem

- Cfr. https://www.nytimes.com/2023/09/11/learning/would-you-want-an-ai-tutor.html#commentsContainer

- Si veda a titolo di esempio https://aieducator.tools/.

- Impostare percorsi di formazione di insegnanti sull’assistenza artificiale alla mediazione didattica, La ricerca online, 12 settembre 2023, consultabile all’indirizzo https://laricerca.loescher.it/impostare-percorsi-di-formazione-di-insegnanti-sullassistenza-artificiale-alla-mediazione-didattica/.

- Qui: https://oecd.ai/en/dashboards/overview.

- S. Giannini, Generative AI and the future of education, UNESCO 2023.

- F. Miao, W. Holmes, Guidance for Generative AI in Education and Research, UNESCO 2023, consultabile all’indirizzo https://unesdoc.unesco.org/ark:/48223/pf0000386693.locale=en.

- Ricordiamo che in Italia l’età minima per l’uso dei social (WhatsApp, Instagram, Tiktok) in modo autonomo è di 14 anni, fra i 13 e i 14 è necessaria l’autorizzazione dei genitori. Telefono Azzurro a febbraio 2023 ha proposto di elevarla a 16 come già previsto dalla regolamentazione europea.