Non parlo in questo articolo di robot come oggetti manipolabili e gestibili dagli studenti, diventati ormai comuni nelle scuole come strumenti di intermediazione per spiegare concetti matematici e scientifici. Parlo invece dei robot “sociali”, finalizzati ad agire come insegnanti o come compagni di classe.

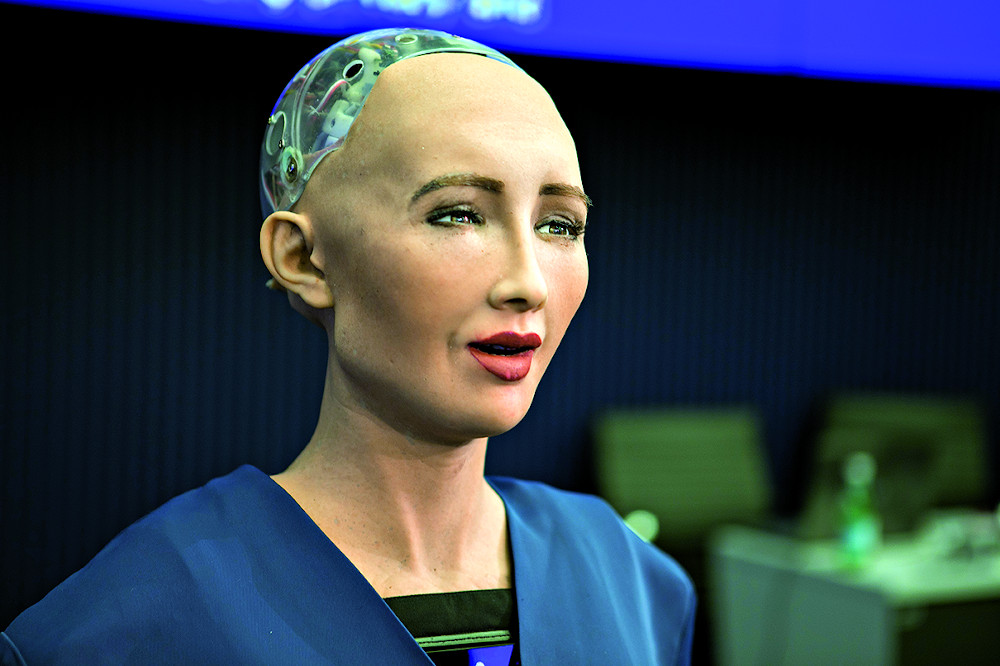

Un esempio è Saya, un robot umanoide telecomandato; un operatore in una sala di controllo può ascoltare e osservare gli studenti mediante videocamere, una delle quali è attaccata a Saya. Da tempo attiva nelle scuole elementari giapponesi, ha un aspetto femminile; è capace di muovere la testa e di assumere espressioni facciali. Quando viene utilizzata in modalità interattiva, può articolare brevi frasi e accompagnarle con un’espressione appropriata: se le si ordina «Taci!» si mostra anche arrabbiata (Hashimoto 2011).

Più spesso, i robot assumono il ruolo di compagni di classe. È il caso di Rubi, un robot socievole a basso costo, finalizzato a migliorare il vocabolario dei bambini più piccoli. Funziona automaticamente e può cantare, ballare, prendere e restituire oggetti usando i suoi attuatori fisici. Può quindi proporre ai bambini giochi mirati allo sviluppo del lessico, passando da un esercizio all’altro in base a un algoritmo, un “rilevatore dell’interesse” che tiene conto del numero di volti rilevati e dei tocchi ricevuti nell’ultimo minuto. Movellan (2009) lo ha testato per due settimane in un asilo, rilevando un miglioramento del 27% nelle conoscenze linguistiche dei bambini.

Kanda (2004) ha descritto un esperimento di 18 giorni in cui due robot Robovie hanno autonomamente interagito con gli alunni di una scuola elementare giapponese. I robot Robovie potevano identificare i bambini tramite i tag wireless [etichette-sensori senza fili. N.d.T.] da loro indossati e quindi potevano chiamarli per nome incoraggiando così l’interazione. Parlavano inglese con un vocabolario di circa 300 frasi e 50 parole chiave. Utilizzando un test di abbinamento fra parole immagini, sono stati riscontrati miglioramenti in quei bambini che interagivano più spesso con il robot. Tre anni dopo (Kanda 2007) l’esperimento è stato ripetuto per un periodo più lungo (otto settimane) e con robot più evoluti, capaci di rilevare la frequenza con cui i singoli bambini interagiscono con essi. Robovie si intrattiene con i bambini anche durante la pausa pranzo e suscita il loro interesse promettendo di rivelare un segreto se trascorrono più tempo con loro (qual è, ad esempio, la sua squadra di baseball preferita).

Altri ricercatori hanno esplorato le interazioni dei piccoli con i robot progettati per suscitare comportamenti di cura. Tanaka (2007) ha osservato le interazioni tra il robot QRIO e i bambini molto piccoli, fra i 18 e 24 mesi. QRIO era governato da un operatore umano che specificava la direzione di marcia, la direzione della testa e sei diversi comportamenti: danzare, sedersi, alzarsi, sdraiarsi, muovere le mani ed emettere risatine (quando i bambini gli accarezzavano la testa). Attraverso un’osservazione prolungata (45 sessioni in cinque mesi), ha trovato prove di un legame a lungo termine tra il robot e i bambini, che hanno sviluppato nei loro confronti rapporti di cura.

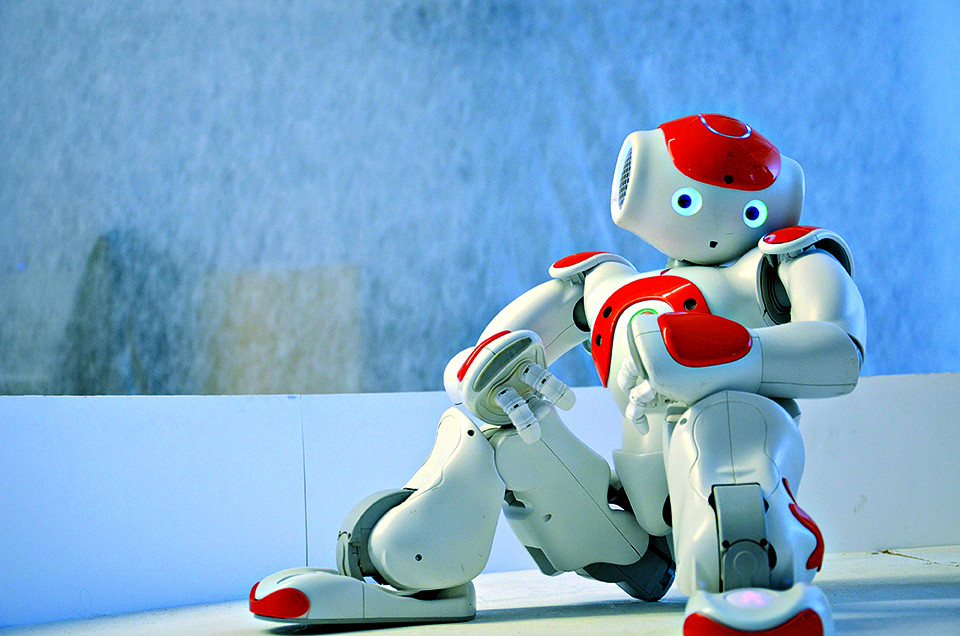

Vi sono poi ricerche in cui sono i bambini che insegnano a un robot. Tanaka (2012) ha introdotto in una scuola di inglese per bambini giapponesi tra 3 e 6 anni un robot di piccole dimensioni che interagisce con loro ma compie anche parecchi errori e sembra quindi aver bisogno del loro aiuto. Risulta che i verbi inglesi sono memorizzati molto meglio quando i bambini si impegnano nell’insegnarli al robot.

Analogamente, in una ricerca condotta da Hood (2015) un gruppo di alunni fra 6 e 8 anni ha insegnato a scrivere a un robot Nao, programmato per fare gli errori più tipici e per migliorare gradualmente le sue prestazioni in base agli esempi da loro disegnati su un tablet. Anche se non è chiaro se ciò abbia migliorato la loro calligrafia, i bambini erano desiderosi di insegnare al robot.

International Communication Union, a Ginevra nel giugno 2017.

Vi sono poi i robot di telepresenza, utilizzati per comunicare tra alunni e insegnanti in classi diverse. Tanaka (2013) riporta uno studio in cui un robot di telepresenza gestito da bambini tra 6 e 8 anni è stato utilizzato per collegare due classi in Australia e Giappone. È risultato che quando i bambini controllavano un robot remoto per interagire con un insegnante di inglese distante erano più coinvolti rispetto a quando interagivano con lui tramite uno schermo di Skype.

Nelle scuole elementari della Corea del Sud è attivo il robot EngKey che insegna l’inglese tramite telepresenza. Ha un aspetto a forma di uovo ed è progettato per sembrare amichevole e accessibile. Consente a insegnanti filippini di insegnare l’inglese agli studenti sudcoreani, migliorandone le prestazioni (Yun 2011).

Sebbene abbiano quasi tutti un aspetto antropomorfico, i robot utilizzati in queste ricerche sono fra loro diversi. Alcuni, come Robovie, sono progettati per funzionare autonomamente, senza input umano, altri si presentano come autonomi ma sono controllati da remoto, come Saya. Altri ancora funzionano in modo semi-autonomo, ammettendo un’eventuale supervisione umana. QRIO, per esempio, mostra un comportamento autonomo ma può anche essere diretto da un operatore umano per rispondere in modo appropriato a ciò che avviene in classe.

Risulta da questa recensione che l’idea degli insegnanti robot non è fantascientifica, ma anche che le loro capacità di operare autonomamente sono ancora limitate, spesso aiutate da interventi umani palesi o nascosti. L’obiettivo di questi studi è capire il grado di accettazione dei robot, più che loro efficacia nell’insegnamento. Al momento, quindi, si stanno ancora esplorando i fattori che influenzano l’interesse dei bambini nei robot, come il sentirsi chiamare per nome o la possibilità di accedere a informazioni privilegiate.

In ogni caso, questi studi dimostrano che i bambini possono imparare dai robot, in particolare nell’area linguistica. Tuttavia non vi sono ancora sufficienti studi comparativi tra l’efficacia di un insegnante umano e uno robotico e neppure sono chiari i fattori che determinerebbero una maggiore efficacia.

Un’altra questione che deve essere esplorata è la misura in cui i bambini si fidano dei robot insegnanti e i fattori che influenzano tale fiducia. Koenig (2013) sottolinea ad esempio che «i bambini non si fidano ciecamente delle parole degli altri», ma mostrano un apprendimento selettivo, e un robot incapace di rispondere a tutte loro domande, anche lontane dalla disciplina insegnata, susciterebbe probabilmente il loro scetticismo. La fiducia nei robot sembra influenzata dall’aspetto e dal suo comportamento, ma conta anche l’argomento, con un massimo per questioni funzionali e tecniche (ad esempio il peso degli oggetti) e un minimo per quelle sociali. […]

I robot sociali: le preoccupazioni etiche

Esaminiamo prima di tutto le preoccupazioni etiche da tempo sollevate riguardo i robot sociali in genere.

La prima riguarda la privacy. I robot sociali possono raccogliere informazioni personali cui possono accedere altre persone. La privacy sarebbe violata se fossero usati per consentire la sorveglianza diretta. Calo (2012) sottolinea la loro capacità di registrare il mondo che li circonda, anche perché è possibile che ad essi sia consentito accesso a spazi storicamente protetti come la casa. Inoltre, approfittando della loro apparente natura sociale, possono estorcere confidenze dalle persone.

Una seconda preoccupazione concerne il rapporto fiduciario che può instaurarsi con il robot. Se questo è costruito per assomigliare a un uomo, o almeno a un essere con emozioni, gli utenti potrebbero aspettarsi che sia in grado di prendersi cura di loro. Ma è una conclusione ingannevole, da tempo discussa nel caso del loro uso nell’assistenza agli anziani, la cui dignità deve essere salvaguardata (Coeckelbergh 2010).

Sono questioni rilevanti anche per i robot destinati all’assistenza dei bambini. Sharkey (2010) ha considerato i Robot Nannies, usati per sostituire le baby sitter, mettendo in questione l’attaccamento particolare che i bambini instaurano con loro. Anche se le tate robot differiscono per molti aspetti dagli insegnanti robot (perché usate in casa, non in classe, quasi sempre con neonati o bambini molto piccoli), è importante che siano rilevati rischi di danni psicologici nel caso di un loro uso prolungato.

Altri hanno espresso preoccupazioni sull’uso dei robot come animali domestici, e Wallach (2009) ha suggerito che le tecniche da essi utilizzate per rispondere ai segnali umani sono «probabilmente forme di inganno». Altre hanno denunciato la perdita di contatto umano che potrebbe derivare dall’uso massiccio di robot sociali Sparrow (2006).

Altri ancora, infine, hanno sollevato questioni relative al controllo e alla responsabilità. Fino a che punto possiamo credere che i robot sappiano prendere decisioni giuste riguardo ai comportamenti umani? E in che misura li si può considerare responsabili di tali decisioni?

un’iniziativa avviata nel 1997 con l’obiettivo di realizzare entro il 2050 una squadra di robot in grado battere la squadra di calcio campione del mondo.

Il problema della privacy nelle classi

Consideriamo ora come queste preoccupazioni generali si articolano riguardo agli insegnanti robot, cominciando dal problema della privacy. La capacità di un robot di interagire con i bambini è abilitata dai sensori, e se questi vengono utilizzati per registrare le informazioni ciò genera preoccupazioni: quali possono essere archiviate e chi è autorizzato ad accedervi?

Ma l’uso di questi sensori potrebbe essere pericoloso anche in assenza di registrazioni. Già oggi, infatti, i robot sono in grado di riconoscere i singoli alunni, chiamarli per nome e rilevare i loro spostamenti tramite etichette elettroniche applicate ai loro abiti. Usando queste funzioni, il robot studiato da Kanda (2007) è in grado di tracciare una mappa delle relazioni di amicizia che si formano fra gruppi di bambini. È inverosimile immaginare che in futuro i robot possano monitorare le relazioni sociali degli alunni, classificare i comportamenti disdicevoli e quindi avvisare l’insegnante?

Negli Stati Uniti questi problemi sono stati sollevati nel 2015 dal presidente Obama e oggi è in programma l’introduzione di uno Student Digital Privacy Act, finalizzato a disciplinare l’uso delle informazioni sugli studenti raccolte nella somministrazione di servizi educativi personalizzati. Si vieta ad esempio la pubblicità mirata e la vendita dei dati. Nel Regno Unito la gestione delle informazioni personali è regolata dal Data Protection Act, ma per rispondere alle nuove sfide della robotica è più che mai necessario un aggiornamento dei criteri stabiliti.

Vi sono anche pericoli di violazioni più intime della privacy suscitate da programmi in grado di riconoscere le espressioni facciali dei bambini e quindi tracciare il loro stato emotivo. E lo stesso obiettivo è consegui- bile con altri metodi: già oggi esiste un braccialetto biometrico chiamato Q-sensor, sviluppato da Affectiva (una società collegata al MIT), finalizzato a misurare la galvanic skin response, l’eccitazione emotiva di chi lo indossa. Potrebbe misurare quando e quanto gli studenti sono coinvolti o annoiati.

Naturalmente, monitorare il coinvolgimento dell’uditorio può essere utile e Mutlu (2012) ha costruito una situazione sperimentale per verificarlo. Ha monitorato in tempo reale l’attenzione degli studenti utilizzando segnali neurali acquisiti con un auricolare EEG wireless mentre un robot umanoide, Wakamaru, raccontava una storia. Il robot era in grado di ravvivare la loro attenzione annuendo con la testa, entrando in contatto visivo, alzando la voce e facendo gesti con le braccia.

I problemi, però, sono numerosi. Alti livelli di eccitazione potrebbero nascere anche da eventi che nulla hanno a che fare con la materia studiata. I comportamenti entusiasmanti del robot potrebbero non comportare affatto una migliore comprensione. E tutto il sistema educativo potrebbe evolvere verso una forma di edutainment in cui sono evitati argomenti potenzialmente noiosi.

Per concludere, anche lo stesso obbligo di indossare sensori emozionali potrebbe essere visto come un’invasione della privacy, capace di indurre di per sé una pesante distorsione nella condizione psicologica degli alunni.

Inganno e perdita del contatto umano

Vi sono infine questioni che nascono dall’illusione che un robot sia in grado di relazionarsi con l’uomo.

I sensori possono consentirgli di interagire favorendo la parvenza di una reale comprensione e apparirà effettivamente reattivo se, rilevando le espressioni dell’interlocutore, risponderà con commenti appropriati. Se poi lo guarderà negli occhi sembrerà addirittura senziente e la capacità di rilevare quando gli si presta attenzione può dare l’illusione che capisca cosa sta succedendo.

Conta naturalmente anche l’aspetto, soprattutto se imita quello umano evitando d’essere troppo simile a un individuo specifico: è infatti inevitabile proiettare sui robot la nostra straordinaria abilità di valutare rapidamente gli atteggiamenti umani e rilevare segni di anomalia. Ad esempio Meah (2014) sottolinea l’importanza che la voce del robot sia ben coerente con il suo aspetto.

Sebbene siano molti ad auspicare robot sempre più interattivi e divertenti, altri sostengono che tale sviluppo sia intrinsecamente ingannevole. Trattando dell’uso dei robot per l’assistenza agli anziani, Sparrow (2006) sostiene che «l’intenzione di ingannare gli altri, anche per il loro beneficio soggettivo, non è mai etica». Wallach (2009) considera anche la capacità dei robot di rilevare segnali sociali e rispondere con gesti appropriati concludendo che «tutte queste tecniche sono probabilmente forme di inganno». Anche Sharkey (2006) sottolinea che molte ricerche sull’intelligenza artificiale dipendono dalla creazione di illusioni e da inganni.

Naturalmente, in questi contesti il termine «inganno» non implica un’intenzione malvagia, e i ricercatori impegnati in questo campo altro non fanno che proseguire nello storico tentativo di costruire automi simili all’uomo. Inoltre il danno creato dai robot sociali non sarà immediatamente evidente, e infine l’inganno su cui si basano non potrebbe realizzarsi senza la collaborazione attiva di coloro che interagiscono con essi, data la ben nota tendenza della psicologia umana a interpretare persino gli oggetti in senso antropomorfo.

Ciò nonostante, esiste il rischio che attribuire ai robot competenze maggiori di quelle che possiedono possa risultare dannoso. Un robot troppo bravo a emulare l’uomo potrebbe suscitare eccessive aspettative (ad esempio un’autorità pari a un insegnante) o essere usato per scopi educativi per i quali non è adatto.

Se un robot viene presentato come un compagno amichevole, i bambini potrebbero immaginare che si preoccupi per loro. Potrebbero sentirsi ansiosi quando è assente o scegliere di trascorrere più tempo con il robot che con i coetanei. Invece di giocare potrebbero abituarsi a dire al proprio compagno robot cosa fare.

Un bambino potrebbe anche sviluppare atteggiamenti crudeli verso un robot pur senza accorgersene. Di conseguenza, potrebbe imparare che i comportamenti cattivi non portano a conseguenze. E, come nota Tanaka (2009), le persone che trattano gli oggetti non viventi con rispetto tendono agire allo stesso modo anche verso gli esseri viventi.

Inoltre, supponiamo che un bambino tratti male un robot: qual è l’impatto che un simile trattamento potrebbe avere sul comportamento dello stesso robot verso gli altri bambini? C’è anche la possibilità che la fiducia di un bambino nelle relazioni possa essere indebolita dalla scoperta che l’amico robot è solo un’entità programmata. Riuscirà poi a stringere amicizia con i coetanei? E come influiranno le abitudini relazionali acquisite con la macchina? Una relazione con un robot somiglia a quella con uno psicopatico: qualsiasi sentimento empatico che provi per lui non è assolutamente ricambiato.

Si potrebbe sostenere che l’attaccamento verso un robot non sia diverso da quello per un peluche. Ma un peluche non si muove e qualsiasi sentimento che il bambino prova per esso si fonda sull’immaginazione. Anche un robot non è un’entità vivente, ma è programmato per comportarsi come se lo fosse e ciò genera confusione. Vi sono ragioni per credere che sia difficile resistere a un robot apparentemente vulnerabile e bisognoso di cure.

Si può paragonare questo attaccamento a quello per un animale domestico. Ma questo è una creatura vivente con la quale il bambino può davvero instaurare una relazione. Anche se non dovremmo immaginare che gli animali provino sentimenti, un cane o un gatto conoscono il bambino e saranno direttamente influenzati dalle sue azioni. Il robot, invece, sarà solo in grado di simulare una risposta affettiva. Forse in futuro anche i robot saranno in grado di provare emozioni, ma nulla ci fa pensare che ciò accadrà presto […].

Controllo e responsabilità

L’idea che i robot possano esercitare un controllo sugli umani, anche (o specialmente) quando sono bambini, dovrebbe essere controversa. Tuttavia, è difficile immaginare come un robot possa funzionare come insegnante senza essere in grado di esercitare una propria autorità. Dovrebbe riconoscere e prevenire comportamenti distruttivi? E dovrebbe premiare quelli positivi?

Si è tentati di pensare che i robot sarebbero più giusti degli umani. Chi durante l’infanzia ha avuto relazioni negative con gli insegnanti può sostenere che un robot non sarebbe mai prevenuto, vendicativo o arrabbiato.

Discussioni simili sono state fatte in altri contesti, dall’assistenza all’ambito militare. Borenstein (2013) suggerisce che i robot potrebbero essere preferibili agli umani perché, se è vero che non conoscono l’empatia, non conoscono neppure il sadismo e l’indifferenza. In un contesto militare, Arkin (2009) ha sostenuto che i soldati robot potrebbero essere più etici degli umani perché privi del desiderio di vendetta. Vi è bisogno, a suo avviso, un protocollo etico per i soldati robot, che li vincoli in modo tale da minimizzare i danni collaterali.

Un insegnante robot potrebbe essere programmato in modo simile per prendere decisioni etiche in classe, ad esempio lodare o castigare i bambini per il loro comportamento? Il problema è che prendere una decisione nel contesto di una classe dipende dalla capacità di discernere tra i diversi tipi di comportamento e di comprenderne le intenzioni. Riconoscere quali bambini si comportano male richiede una buona comprensione delle motivazioni che li muovono. Un bambino tranquillo potrebbe voler solo studiare e rifiutare imbarazzato di partecipare alla vita sociale. Un bambino scalmanato potrebbe sia contribuire attivamente alla discussione in classe sia interferire con essa.

Il problema è aggravato dalla rapidità con cui i bambini cambiano; un ragazzo che prima studiava può trasformarsi in fannullone. Affinché un robot eserciti un controllo efficace (ed equo) sul loro comportamento dovrebbe riuscire a prevedere le loro probabili azioni successive e avere strategie per incoraggiare atteggiamenti virtuosi. Sono abilità che i migliori insegnanti sfruttano in modo efficace. Potrebbe averle un robot? Sembra improbabile nel prossimo futuro. E ci sono buoni motivi per pensare che non accadrà neanche in quello lontano. Il punto decisivo è che è che si può distinguere fra comportamenti buoni e cattivi solo in base al senso morale, che a sua volta non può prescindere da un sostrato biologico.

Churchland (2011) ricorda come la moralità dipenda dalla biologia dei processi cerebrali: la propensione alla cura degli altri, la condivisione empatica dei loro stati psicologici e gli atteggiamenti socialmente costruttivi sono comportamenti da una parte condivisi da tutti i mammiferi e ben radicati nella loro costituzione biologica, dall’altra in stretta relazione con la neurochimica dei loro cervelli, tanto da essere modificati da sostanze come i neuropettici, l’ossitocina, l’arginina e la vasopressina. Di fatto, quando sanno che i loro bambini sono al sicuro, gli esseri umani provano un effettivo piacere, e sviluppano ansia anche quando è minacciato il benessere degli altri, non il loro. Questo implica che i robot non hanno la necessaria natura biologica richiesta per un senso di moralità. E senza questo, come potrebbero prendere decisioni eque?

L’insegnante robot dovrebbe decidere mediante regole programmate, ma la loro efficacia dipenderà dalla capacità del programmatore di prevedere le situazioni che potrebbero sorgere. E in una classe queste possono cambiare a una velocità tale da rendere impossibile le previsioni. I robotisti hanno iniziato a considerare lo sviluppo dell’empatia artificiale, ma questa ricerca è in una fase iniziale. Nel frattempo, la mancanza di comprensione del comportamento dei bambini costituisce un grosso handicap per gli insegnanti robot.

Inoltre i robot non sono necessariamente equi e imparziali. Dato che sono sviluppati da esseri umani, possono riproporre i loro pregiudizi. Nel 2009, ad esempio, si è scoperto che gli algoritmi di tracciamento dei volti delle webcam Hewlett-Packard funzionavano solo con facce bianche e non con quelle nere. Il problema è stato successivamente risolto e di certo la Hewlett-Packard non aveva intenzioni razziste; semplicemente gli sviluppatori non avevano notato che i loro algoritmi non funzionavano bene con la pelle nera. Per garantire che un robot tratti tutti allo stesso modo, i programmatori dovrebbero considerare anche le eventuali disuguaglianze che i sensori del robot potrebbero generare.

Infine, gli insegnanti robot sollevano problemi legali connessi alla responsabilità. Ai sensi del Children Act del 1989, gli insegnanti hanno il dovere di prendersi cura degli alunni, di premiarli o punirli sulla base di un concetto legale denominato in loco parentis. Sebbene non vincolati dalla responsabilità parentale, devono comportarsi come farebbe un genitore ragionevole. Questo principio giustifica un uso ragionevole delle punizioni, con esclusione di quelle corporali, ormai fuorilegge nella maggior parte dell’Europa.

È improbabile che questo venga applicato a un robot, ma d’altra parte se lo si assume come insegnante bisogna conferirgli un potere sanzionatorio. Potrebbe ad esempio dover impedire a un bambino di compiere azioni pericolose, di ferire i compagni o il robot stesso. Ma non è chiaro quali tipi di sanzioni potrebbe usare in modo accettabile.

Tratto da: A.J.C. Sharkey, Should we welcome robot teachers?, in «Ethics Inf Technol», 18, pp. 283–297, 2016.

Traduzione di Francesca Nicola.

Bibliografia

R. Arkin, Governing lethal behavior in autonomous robots. Chapman-Hall review, in «Computers and Education», 58(3), pp. 978–988, 2009.

J. Borenstein, Y. Pearson, Companion robots and the emotional development of children. Law, in «Innovation and Technology,» 5(2), pp. 172–189, 2013.

M. R. Calo, Robots and privacy, in P. Lin, K. Abney, G. A. Bekey, Robot ethics: The ethical and social implications of robotics, The MIT Press, London 2012.

P. S. Churchland, Braintrust: What neuroscience tells us about morality, Princeton University Press, Oxford 2011.

M. Coeckelbergh, Health care, capabilities, and AI assistive technologies, in «Ethical Theory and Moral Practice», 13(2), pp. 181–190, 2010.

T. Hashimoto, N. Kato, H. Kobayashi, Development of educational system with the android robot SAYA and evaluation, in «International Journal Advanced Robotic Systems», 8(3), pp. 51–61, 2011.

D. Hood, S. Lemaignan, P. Dillenbourg, When children teach a robot to write: an autonomous teachable humanoid which uses simulated handwriting, in «HRI ’15», marzo 02–05, Portland, OR, USA, 2015.

T. Kanda, T. Hirano, D. Eaton, H. Ishiguro, Interactive robots as social partners and peer tutors for children: A field trial, in «Human Computer Interaction», 9, pp. 61–84, 2004.

T. Kanda, R. Sato, N. Saiwaki, H. Ishiguro, A two-month field trial in an elementary school for long-term human–robot interaction, in «IEEE Transactions on Robotics», 23(5), pp. 962–971, 2007.

M. Koenig, M- A. Sabbagh, Selective social learning: New perspectives on learning from others, in «Developmental Psychology», 49, pp. 399–403, 2013.

L.F.S. Meah, R.K. Moore, The uncanny valley: A focus on misaligned cues, in M. Beetz, B. Johnston, M. Williams, Social Robotics, vol. 8755, , pp. 256–265, 2014.

J. Movellan, M. Eckhart, M. Virnes, A. Rodriguez, Sociable robot improves toddler vocabulary skills, in «Proceedings of 2009 international conference on human robot interaction», 2009.

B. Mutlu, D. Szafir, Pay Attention! Designing adaptive agents that monitor and improve user engagement, in «Proceedings of Human Factors in Computing», 2012.

N. E. Sharkey, A.J.C. Sharkey, The crying shame of robot nannies: An ethical appraisal, in «Interaction Studies», 11(2), pp. 161–190, 2010.

N. E. Sharkey, A.J.C. Sharkey, Artificial intelligence and natural magic, in «Artificial Intelligence Review», 25, pp. 9–19, 2006.

R. Sparrow, L. Sparrow, In the hands of machines? The future of aged care, in «Mind and Machine», 16, pp. 141–161, 2006.

F. Tanaka, A. Cicourel, J. R. Movellan, Socialization between toddlers and robots at an early childhood education center, in «Proceedings of the National Academy of Science», 194(46), pp. 17954–17958, 2007.

F. Tanaka, T. Kimura, The use of robots in early education: a scenario based on ethical consideration, in «Proceedings of the 18th IEEE international symposium on robot and human interactive communication», pp. 558–560, 2009.

F. Tanaka, S. Matsuzoe, Children teach a care-receiving robot to promote their learning: Field experiments in a classroom for vocabulary learning, in «Journal of Human–Robot Interaction», 1(1), pp. 78–95, 2012.

F. Tanaka, T. Takahashi, S. Matsuzoe, M. Morita, Child-operated telepresence robot: A field trial connecting classrooms between Australia and Japan, in «Proceedings of IEEE/RSJ international conference on intelligent robots and systems (IROS 2013)», Tokyo, Japan, pp. 5896–5901, 2013.

W. Wallach, C. Allen, Moral machines: Teaching robots right from wrong, Oxford University Press, New York 2009.

S. Yun, J. Shin, D. Kim, C.G. Kim, M. Kim, M. T Choi, Engkey: Tele-education robot, In B. Mutlu, Social robotics: Proceedings of the third international conference on social robotics, LNAI 7072, pp. 142–152, 2011